簡單。

快速。

可擴充。

統一。

快速。

可擴充。

統一。

主要功能

批次/串流資料

使用您偏好的語言:Python、SQL、Scala、Java 或 R,統一批次和即時串流中資料的處理。

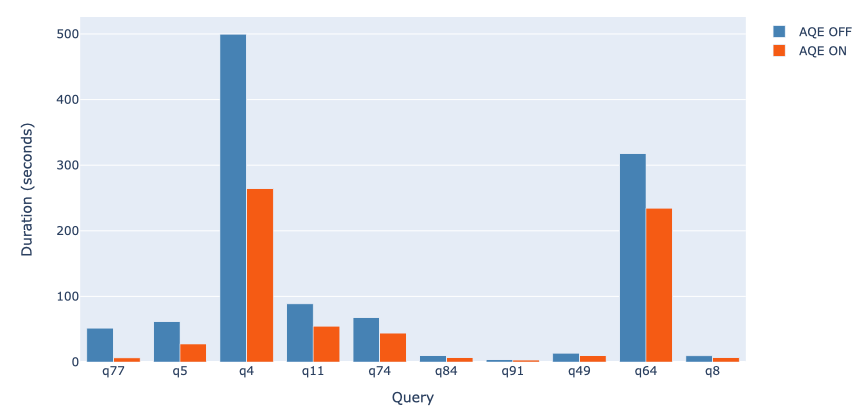

SQL 分析

執行快速、分散的 ANSI SQL 查詢,以進行儀表板和臨時報告。執行速度比大多數資料倉庫快。

大規模資料科學

對 PB 等級的資料執行探索性資料分析 (EDA),而無需訴諸於降採樣

機器學習

在筆記型電腦上訓練機器學習演算法,並使用相同的程式碼擴充到容錯叢集,其中包含數千台機器。