Spark SQL 是 Apache Spark 的模組,可用於處理結構化資料。

整合

將 SQL 查詢與 Spark 程式無縫結合。

Spark SQL 讓您可以在 Spark 程式中查詢結構化資料,使用 SQL 或熟悉的 資料框架 API。可在 Java、Scala、Python 和 R 中使用。

results = spark.sql(

"SELECT * FROM people")

names = results.map(lambda p: p.name)

"SELECT * FROM people")

names = results.map(lambda p: p.name)

將函式套用至 SQL 查詢結果。

統一的資料存取

以相同的方式連線至任何資料來源。

資料框架和 SQL 提供一種常見的方式來存取各種資料來源,包括 Hive、Avro、Parquet、ORC、JSON 和 JDBC。您甚至可以跨這些來源加入資料。

spark.read.json("s3n://...")

.registerTempTable("json")

results = spark.sql(

"""SELECT *

FROM people

JOIN json ...""")

.registerTempTable("json")

results = spark.sql(

"""SELECT *

FROM people

JOIN json ...""")

查詢和加入不同的資料來源。

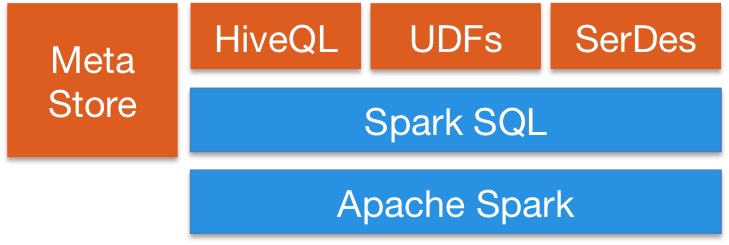

Hive 整合

在現有資料倉儲上執行 SQL 或 HiveQL 查詢。

Spark SQL 支援 HiveQL 語法以及 Hive SerDes 和 UDF,讓您能夠存取現有的 Hive 資料倉儲。

Spark SQL 可以使用現有的 Hive 中繼資料儲存、SerDes 和 UDF。

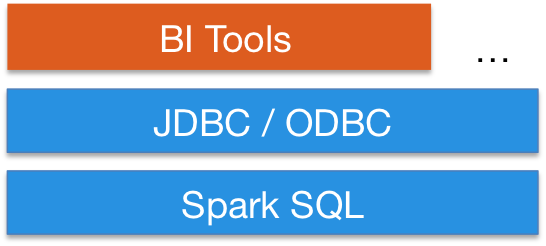

標準連線

透過 JDBC 或 ODBC 連線。

伺服器模式提供業界標準 JDBC 和 ODBC 連線,適用於商業智慧工具。

使用您現有的商業智慧工具查詢大資料。

效能和可擴充性

Spark SQL 包含成本基礎最佳化器、欄位儲存和程式碼產生,以加快查詢速度。同時,它使用 Spark 引擎擴充至數千個節點和多小時查詢,該引擎提供完整的查詢中斷容錯。無需擔心使用不同的引擎來處理歷史資料。

社群

Spark SQL 是 Apache Spark 的一部分。因此,它會在每次 Spark 發布時進行測試和更新。

如果您對系統有任何疑問,請在 Spark 郵件列表 中詢問。

Spark SQL 開發人員歡迎貢獻。如果您想提供協助,請閱讀 如何貢獻 Spark,並向我們發送程式碼修補程式!

最新消息

- Spark 3.4.3 發布 (2024 年 4 月 18 日)

- Spark 3.5.1 發布 (2024 年 2 月 23 日)

- Spark 3.3.4 發布 (2023 年 12 月 16 日)

- Spark 3.4.2 發布 (2023 年 11 月 30 日)